Cómo detectar si un video fue generado por inteligencia artificial: las señales que delatan el engaño

Los deepfakes y videos generados por inteligencia artificial avanzan más rápido de lo que aprendemos a detectarlos. Pero los especialistas aseguran que todavía es posible reconocer un video falso si se observan ciertas pistas clave.

“Ver para creer”. Este dicho popular parte de una idea simple: algo solo se vuelve real o verdadero cuando nuestros ojos pueden dar fe de ello. Así, durante décadas, un video era suficiente para probar que un hecho había ocurrido.

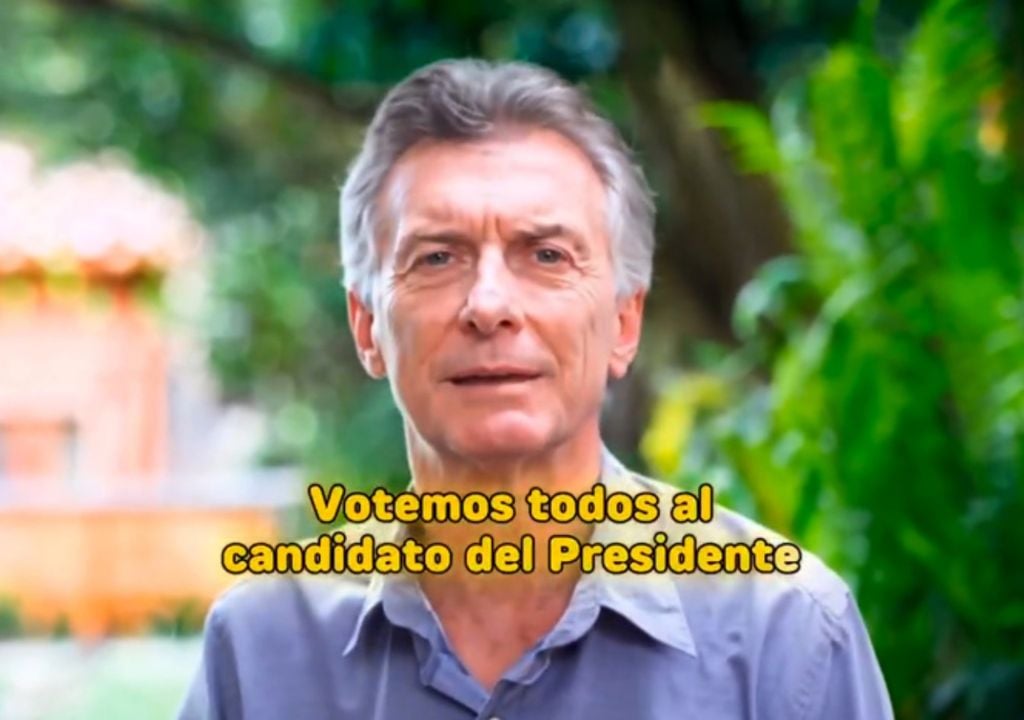

Ese criterio, sin embargo, se ha resquebrajado. En la era de la inteligencia artificial, un video puede mostrar lo que nunca pasó. Y aunque muchos crean que podrían detectar el engaño, lo cierto es que las tecnologías, las técnicas y las artimañas se han vuelto tan sofisticadas que logran confundir incluso a los ojos más entrenados.

Lo inquietante es que la IA no solo altera las imágenes: también moldea nuestra confianza en lo que vemos, con implicancias que van desde lo cotidiano hasta la configuración de la opinión pública y las preferencias políticas.

Los llamados deepfakes y los videos generados por IA están desafiando nuestra noción de evidencia, de confianza y, en última instancia, de verdad. ¿Cómo saber si lo que vemos es falso? Aún hay algunas pistas, aunque quizás no por mucho tiempo.

Tres pistas: resolución, calidad y duración

Puede sonar contraintuitivo, pero una de las principales señales de un video falso es justamente su baja calidad. “Es una de las primeras cosas que analizamos”, declaró a la BBC Hany Farid, profesor de informática en la Universidad de California, Berkeley, pionero en análisis forense digital y fundador de la empresa GetReal Security.

Imágenes granuladas, bordes difusos, colores lavados: esa apariencia puede ser una elección deliberada. Los videos borrosos ocultan las pequeñas inconsistencias con las que la IA todavía tropieza, como parpadeos raros, texturas de piel demasiado suaves, reflejos imposibles o cabellos que cambian de forma.

Farid explicó que los creadores de falsificaciones rebajan la resolución intencionalmente. “Si quiero engañar a la gente, genero mi video falso, luego reduzco la resolución y le añado compresión para disimular cualquier posible defecto”, dijo a la BBC. Es una técnica sencilla y eficaz.

Los clips falsos suelen ser más breves -entre seis y diez segundos-, porque generar videos largos requiere más recursos y aumenta el riesgo de errores visibles. Además, los generadores tienden a comprimir los archivos para esconder las “costuras” digitales que podrían delatarlos.

Un ejemplo viral lo dejó en evidencia: el video de los conejitos saltando en un trampolín, visto más de 240 millones de veces en TikTok. Parecía una tierna grabación nocturna de cámara de seguridad, pero era completamente falso.

Lo mismo ocurrió con la pareja que se enamoraba en el metro o con el predicador estadounidense que lanzaba un sermón anticapitalista. Todos tenían en común ese aspecto pixelado, casi amateur, que los hacía creíbles.

Un futuro sin pistas visibles

El problema es que esas señales están desapareciendo. “Tengo malas noticias”, advirtió a la BBC Matthew Stamm, profesor en la Universidad de Drexel y director del Laboratorio de Multimedia y Seguridad de la Información. “Preveo que estas señales visuales desaparecerán del video en dos años. Ya no podrás fiarte de lo que ves.”

Los modelos más avanzados, como Sora (OpenAI) o Veo (Google), ya producen clips que rozan la perfección. Ante eso, los investigadores recurren a métodos forenses más finos: rastrean “huellas estadísticas” invisibles en los píxeles, imperceptibles para el ojo humano. “Modificar un video deja rastros, como huellas dactilares en una escena de crimen”, explicó Stamm.

Al mismo tiempo, las grandes empresas tecnológicas trabajan en sistemas para garantizar la autenticidad: cámaras que registren el origen del archivo, o marcas digitales que permitan saber si un contenido fue creado por IA.

Denominación de origen: el valor de quién publica

Cuando ya no se puede confiar en los ojos, se vuelve esencial confiar en las fuentes. El experto en alfabetización digital Mike Caulfield lo expresó con claridad en diálogo con la BBC: “El video se convertirá en algo parecido al texto: la procedencia, y no las características superficiales, será lo más importante”.

Saber quién publica un video puede ser hoy la mejor defensa contra la manipulación. No es lo mismo un clip anónimo en redes que una grabación difundida por un medio con reputación y trazabilidad. En este esquema, la credibilidad se desplaza del contenido al emisor o la fuente.

La tecnología, entre la filosofía y la política de la verdad

El problema de los videos falsos es, en última instancia, un tema filosófico y político. Si la vista ya no basta para discernir, la noción misma de verdad -base del periodismo, de la justicia, de la democracia- entra en crisis.

“Creo que este es el mayor desafío de seguridad informática del siglo XXI”, sostuvo Stamm. Resolverlo requerirá tecnología, educación digital y pensamiento crítico.

Mientras tanto, entre algoritmos, deepfakes y posverdad, el llamado a estar atentos es cada vez más importante y urgente. La duda, como método, nunca fue tan necesaria. Y el pensamiento crítico parece ser, hoy, la única garantía de no perder del todo el sentido de la realidad.